‘Amazon, stop verkoop software voor gezichtsherkenning’

Een groep van 25 prominente onderzoekers op het gebied van kunstmatige intelligentie roept Amazon in een open brief op om te stoppen met de verkoop van Rekognition, software voor gezichtsherkenning aan politiekorpsen. De software kan nadelig uitwerken voor vrouwen en mensen met een donkere huidskleur.

Onder de uitgebreide open brief staan de namen van onderzoekers van bekende universiteiten (waaronder de recente winnaar van de Turing Award, Yoshua Bengio, pionier op het gebied van kunstmatige intelligentie), maar ook van bedrijven als Google en Facebook. Zij roepen Amazon op om te stoppen met de verkoop van gezichtsherkenning-software Rekognition aan politiekorpsen in de VS, zolang er geen wetgeving en waarborgen zijn om discriminatie te voorkomen.

Rekognition is software voor geautomatiseerde gezichtsherkenning, die het mogelijk maakt om op basis van bekende foto’s van mensen, in nieuwe beelden die mensen te identificeren. Amazon biedt de dienst aan via zijn afdeling Amazon Web Services.

Zorgen

De open brief laat zien dat veel onderzoekers (zowel op universiteiten als bij bedrijven) zich zorgen maken over de stand van zaken op het gebied van automatische gezichtsherkenning. Hoewel deze technologie in potentie tal van nuttige toepassingen heeft, is het oppassen geblazen met de vooringenomenheid van dergelijke software. Keer op keer blijkt dat de software minderheden oneerlijk behandelt.

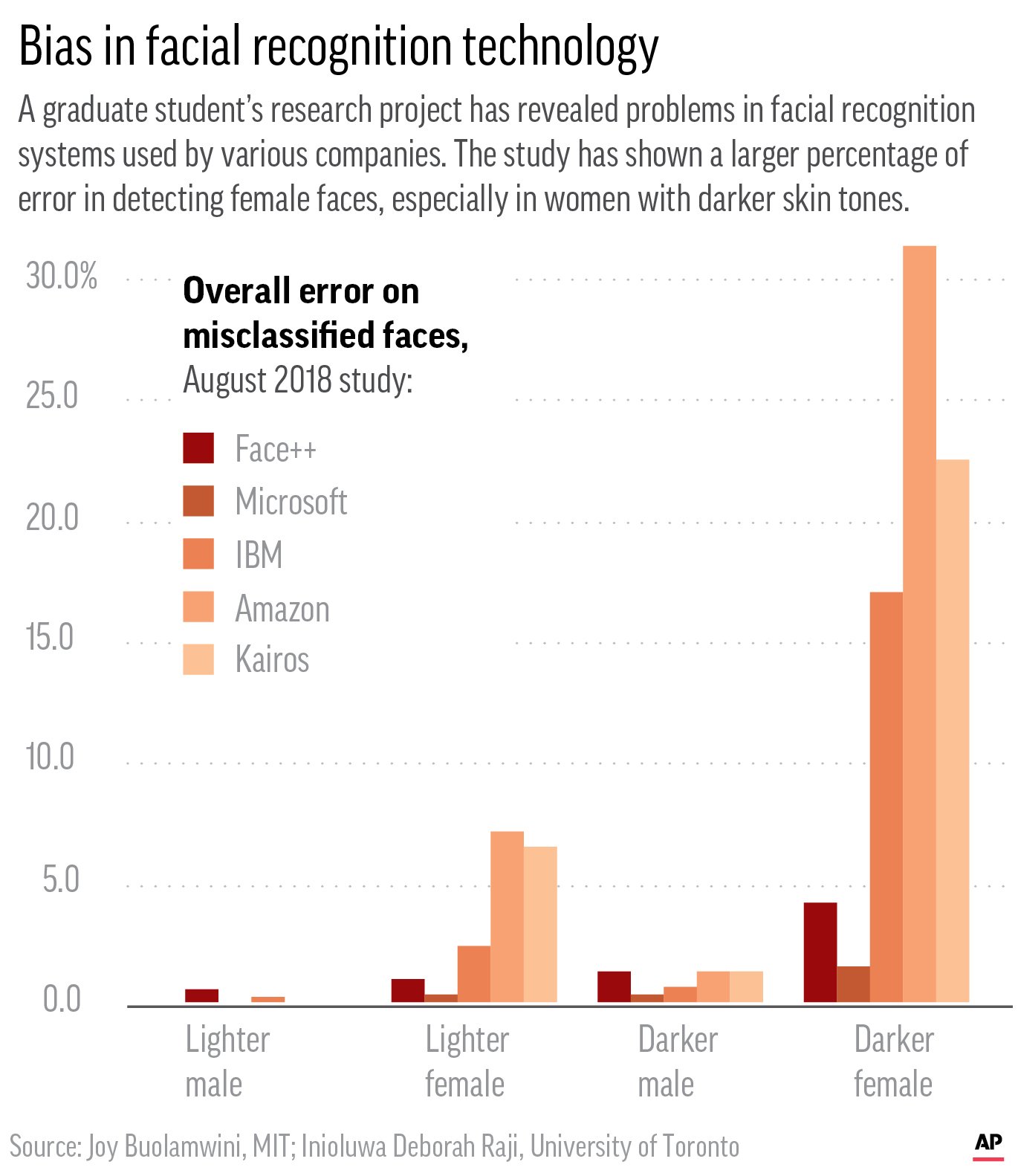

gezichten gaat veel vaker de fout in bij vrouwen

dan bij mannen. Bij vrouwen met een donkere

huidskleur is de betrouwbaarheid helemaal slecht.

Figuur Joy Buolamwini, MIT.

In januari lieten twee MIT-onderzoekers zien dat Rekognition van Amazon veel meer moeite had om op basis van foto’s het geslacht van iemand te bepalen, als het ging om vrouwen of mensen met een donkere huidskleur. Donkere vrouwen werden abusievelijk herkend als man in 31 % van de gevallen; bij vrouwen met een lichtere huidskleur lag dit op 7 %. Bij 1 % van de (foto’s van) donkere mannen ging de software de fout in, tegen 0 % bij lichtgekleurde mannen, zo meldde Associated Press destijds. Deze hoge foutenmarges leveren het risico op dat mensen met een donkere huidskleur gediscrimineerd worden.

Tegenaanval

Een van de MIT-onderzoekers, Joy Buolamwini, legde de resultaten voor aan Amazon, maar in plaats van hun software te verbeteren (wat onder meer Microsoft en IBM wel deden), ging het bedrijf in de tegenaanval. In een paar blogposts probeerden Amazon-medewerkers de bevindingen van Buolamwini te weerleggen. De open brief van gisteren is hier een uitgebreide reactie op.

De specialisten van Amazon schreven in hun blogposts dat er tot nu toe geen verkeerd gebruik gemeld van de Rekognition-software. Dat is niet zo raar, reageren de gezamenlijke AI-onderzoekers, ‘want er is momenteel geen wet die voorschrijft dat het gebruik van gezichtsherkenning-software gecontroleerd moet worden. Amazon heeft ook niet alle klanten bekendgemaakt die de software gebruiken, en evenmin wat de foutenpercentages zijn onder verschillende bevolkingsgroepen.’ Met andere woorden: we hebben geen idee hoe de Amazon-gezichtsherkenning presteert en of er burgers door worden benadeeld.

Ras en etniciteit

In dezelfde blogposts zegt Amazon dat er bij een proef met het automatische herkennen van het geslacht uit een dataset van 12.000 gezichten geen ongelijkheden naar voren kwamen tussen verschillende etniciteiten. Dat zal misschien zo zijn, counteren de wetenschappers, maar ras en etniciteit zijn helemaal geen goede grootheden om mee te werken, omdat het sociale constructen zijn; ras en etniciteit kunnen op andere plekken op de wereld (én in andere tijden) anders worden benoemd. Volgens hen kun je gezichten veel beter labellen op een (bestaande) schaal voor huidskleur; dat is objectiever.

Geen training

Eerder ontdekten journalisten van Gizmodo al dat een van de bedrijven die Rekognition gebruiken, zijn medewerkers hiervoor geen speciale training geeft. Dit is problematisch, betogen de bezorgde wetenschappers in hun open brief, want een verkeerd gebruik van software voor gezichtsherkenning kan in de praktijk nare gevolgen hebben. Als bijvoorbeeld de politie er gebruik van maakt, kan het leiden tot het oppakken van onschuldige mensen.

Uitkomst kritisch benaderen

Daar komt nog bij dat politiemensen vaak niet voldoende kennis hebben van de software voor gezichtsherkenning om de beperkingen te snappen. Een beslissing van zo’n systeem kan als ontegenzeggelijk juist overkomen, terwijl er altijd een bepaalde onzekerheid in zit; dit heet automation bias. Mensen zijn dan vaak geneigd om het geautomatiseerde systeem te geloven, terwijl je de uitkomst juist kritisch zou moeten benaderen.

Openingsbeeld Amazon Web Services