Lerende computerneuronen

Voor betere beeld- en spraakherkenning en vertalingen kopen datagiganten als Google de laatste tijd bedrijfjes op die in deep learning zijn gespecialiseerd. Daarmee beleeft de oude computertechniek van neurale netwerken een opleving. ‘Deep learning krijgt nog veel toepassingen in het internet der dingen.’

Hoe leer je een computer foto’s of gesproken taal herkennen? Antwoord: je laat het hem zelf uitzoeken. Deep learning, een techniek waarmee computers zichzelf leren patronen in gegevens te ontdekken, is bij de grote databedrijven de nieuwe trend. De laatste tijd kopen ze links en rechts kleine bedrijfjes op die erin gespecialiseerd zijn. Qualcomm nam bijvoorbeeld Euvision over, een spin-out van de Universiteit van Amsterdam die zich met beeldherkenning bezighoudt. En Google, dat eerder dit jaar al het Britse DeepMind kocht, verwierf kortgeleden twee spin-outs van de University of Oxford: Dark Blue Labs (taalanalyse) en Vision Factory (beeldherkenning). ‘Het aantal specialisten in de wereld is nog beperkt. Overnames zijn de beste manier om de kennis snel in huis te halen’, is de verklaring van prof.dr. Max Welling, hoogleraar Machine Learning aan de Universiteit van Amsterdam.

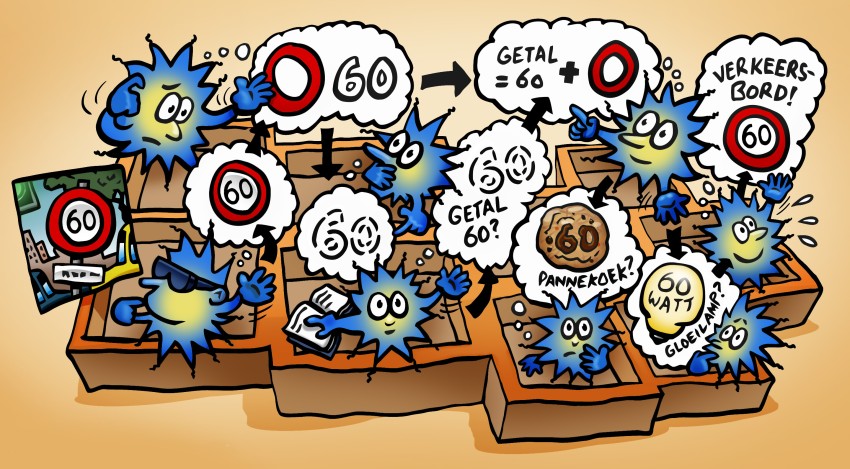

Deep learning is een nieuwe naam voor een oude, half vergeten techniek die een tweede (of derde) leven heeft gekregen: het neurale netwerk. De computer simuleert daarbij het gedrag van de neuronen en hun onderlinge verbindingen in het menselijk brein. Een binnenkomend signaal, bijvoorbeeld een foto met een huisnummer erop, wordt door enkele virtuele neuronen in het netwerk bemeten. Ze vuren als ze er een of ander primitief kenmerk in ontdekken (‘linker bovenhoek is donker’). Dat vuren stimuleert, via verbindingen die sterk of zwak kunnen zijn, een volgende laag neuronen om eveneens te vuren en daarmee de volgende stap in de beeldverwerking te zetten. Zo gaat het verder, totdat de laatste neuronenlaag een patroon afvuurt dat vertelt welk huisnummer er op de foto staat. Het aantrekkelijke van neurale netwerken is het feit dat ze net als het brein kunnen leren van hun ervaringen. Welling: ‘Om zo’n netwerk te trainen gebruik je heel veel voorbeeldinput, bijvoorbeeld een paar miljoen plaatjes. Je bepaalt telkens hoe sterk de output verschilt van het gewenste antwoord en past dan de sterkte van alle verbindingen zo aan dat het verschil iets kleiner wordt.’

Niet vergeten

Dat klinkt mooi, maar neurale netwerken golden toch als passé? ‘De eerste modellen hadden alleen een input- en een outputlaag en konden gewoon te weinig, waardoor de interesse na een paar jaar verflauwde’, antwoordt Welling. ‘Het is vooral aan één onderzoeker, Geoffrey Hinton, te danken dat de techniek nooit helemaal is vergeten. In de jaren tachtig ontdekte hij hoe je modellen met meerdere lagen moest trainen, wat tot nieuw enthousiasme leidde. Maar na een paar jaar verschoof de aandacht weer naar andere lerende systemen, waarvan het gedrag beter te voorspellen was.’

Dat was niet het einde van het verhaal, want in 2009 kwam Hinton opnieuw met een doorbraak. Welling: ‘De makke van neurale netwerken was dat aan het begin van de training hun aandacht nogal eens werd gevangen door weinig relevante kenmerken, waar ze later niet meer van los konden komen. Hinton loste dat op door zo’n netwerk voorafgaand aan de training globaal al de goede kant op te sturen.’ Dat proces, dat Hinton pretraining noemde, verschilt van de gewone training doordat er niet wordt vergeleken met een gewenste output. Het netwerk krijgt een berg voorbeelddata aangeboden, waar het domweg een waarschijnlijkheidsverdeling van maakt. Zo komt het onder meer alvast te weten dat de pixels boven in een foto vaak lichtblauw zijn – de lucht – en dat zo’n gebied meestal geen interessante vormafwisseling bevat.

‘Dat werkte ineens heel goed’, vertelt Welling. ‘Microsoft boekte in die tijd nauwelijks nog voortgang met het onderzoek naar spraakherkenning; de jaarlijkse verbetering was minimaal geworden. Hinton en zijn collega’s wisten de foutmarge in één keer met vele procenten te verkleinen – een echte klapper. Een paar jaar later gaf dezelfde groep op een soortgelijke manier alle specialisten op het gebied van beeldherkenning het nakijken. Sindsdien wordt deep learning ook gebruikt voor vertaalsystemen en berekeningen aan het vouwen van eiwitten.’ En voor MRI-scans: Scyfer, een door Welling met collega-onderzoekers opgericht bedrijf, werkt daaraan in samenwerking met het AMC. Het levert ‘een flinke verbetering’ op in de kwaliteit van de driedimensionale beelden.

‘Merkwaardig genoeg blijkt pretraining de laatste tijd toch niet voor alle soorten data nodig’, vervolgt Welling zijn verhaal. ‘Het lijkt vooral de toegenomen rekenkracht te zijn waardoor neurale netwerken tot hun recht komen. Ze draaien dan ook allemaal op grafische processors.’ Rest de vraag waarom de datagiganten speciaal investeren in deze leertechniek, terwijl er ook andere zijn. Welling: ‘Een neuraal netwerk kun je net zo groot maken als je wilt. Dat past bij de grote hoeveelheden data die de bedrijven verwerken: big data, big models. Bovendien blinken neurale netwerken precies uit op de gebieden waarin zij geïnteresseerd zijn: spraak en taal, beelden en video.’

Hoe groot is de potentie van deep learning? Hoewel Welling vindt dat het enthousiasme van sommigen momenteel doorslaat, gelooft hij dat er nog veel nieuwe toepassingen zullen komen. ‘Speciaal voor het internet of things: sensoren in je lichaam, je auto, je huis. Deep learning is heel geschikt om in al die datastromen patronen te herkennen.’

tekst drs.Timo Können illustratie Peter Welleman