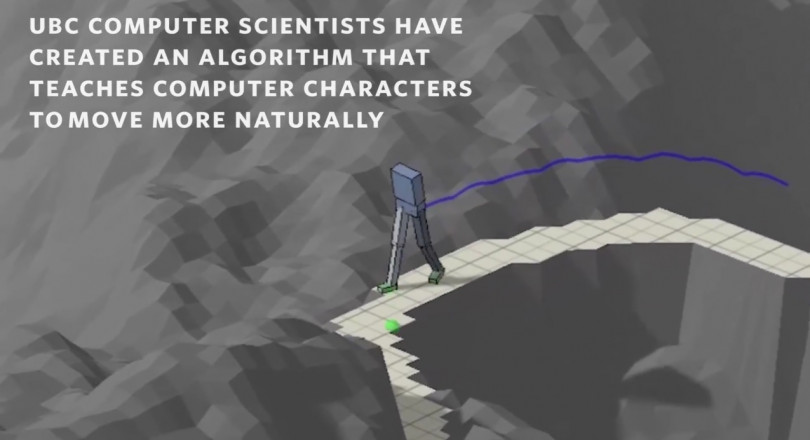

Een nieuw algoritme laat computers uit zichzelf leren hoe je op menselijke wijze kan lopen. De makers zien onder andere toepassingen voor animatiefilms.

De menselijke manier van lopen is een van de ingewikkeldste bewegingen die er is. Programmeurs van humanoïde robots worstelen al jaren met een simpele wandeling: robots vallen om of lopen heel langzaam. Dat komt doordat elke stap een heleboel berekeningen vereist; hoewel je er waarschijnlijk nooit over nadenkt, gebeurt er tijdens het lopen een hoop in je brein, je knieen, enkels, spieren en voeten. Dat allemaal expliciet berekenen, blijkt geen eenvoudige klus.

Deep learning kan misschien uitkomst bieden, dacht de Canadese onderzoeker Michiel van der Panne. Hij bouwde een programma dat met minimale voorkennis leert lopen in allerlei omgevingen: smalle paadjes, wegen met veel obstakels, enzovoort.

Twee algoritmes

Het programma van Van der Panne bestaat feitelijk uit twee algoritmes. Een houdt zich bezig met de precieze bewegingen die nodig zijn voor natuurlijk loopgedrag: de houding van de heupen en knieën, en het juiste looptempo, bijvoorbeeld. Het andere algoritme kijkt op een grotere schaal en vertelt de virtuele benen waar obstakels liggen en hoe die het best zijn te ontwijken.

Vooral de minimale voorkennis van het programma is nieuw. Als robotbouwers nu een machine willen leren lopen, trainen ze hem met een algoritme dat vaak al veel weet. Met de hand hebben ze dan de basis van het lopen ingeprogrammeerd. Het zelflerende programma perfectioneert vervolgens de beweging.

Het programma van Van der Panne begint echter met weinig kennis en onderzoekt in rap tempo verschillende mogelijke bewegingen. Via een ingebouwd beloningssysteem kiest het programma de beste beweging en bouwt daarop verder. Zo ontstaat al snel een heel natuurlijk ogende manier van wandelen.

Motion capture

Als eerste toepassing denken de onderzoekers aan animatie in (teken)films en videospelletjes. Daar gebruikt men nu vaak motion capture: een acteur of actrice hult zich in een pak vol sensoren en de studio kopieert de bewegingen van de acteur naar een virtueel personage. Dat proces kost echter veel tijd en geld. Met dit programma is er straks misschien minder motion capture nodig; de beenbewegingen van een personage komen dan gewoon uit de computer.

In de verdere toekomst kan het programma ook van pas komen om menselijke robots te leren lopen. Dat duurt echter nog wel even; voorlopig is de techniek niet goed genoeg doordat de benen te langzaam reageren en er nog krachtige computers nodig zijn om de berekeningen te doen. Als die computers straks eenmaal in een klein robotje passen, kan het algoritme grote invloed hebben op menselijke robots.

Nieuwsbrief

Vond je dit een interessant artikel, abonneer je dan gratis op onze wekelijkse nieuwsbrief.