Deep learning gaat mis door uitzonderingen

Computers met kunstmatige intelligentie blijken slecht om te kunnen gaan met bijzondere situaties. Een nieuw onderzoek dat ‘randgevallen’ van zogenoemde deep-learning-algoritmes verkent, laat bijvoorbeeld zien dat zelfrijdende auto’s in specifieke gevallen eenvoudig kunnen crashen.

Onderzoekers van Lehigh University en Columbia University schreven een testprogramma om zulke randgevallen op te sporen en de algoritmes te corrigeren. Ze hopen dat bedrijven die veel werken met zelflerende algoritmes hun techniek gebruiken om de software ook veilig te maken in uitzonderlijke situaties, die misschien niet vaak voorkomen tijdens de training van een algoritme.

De randgevallen blijken een belangrijk zwak punt te zijn van deep-learning-algoritmes. Deze computerprogramma’s worden de laatste jaren veel gebruikt omdat ze in relatief weinig tijd complexe dingen kunnen leren. Een deep-learning-algoritme verwerkt gegevens via een kunstmatig brein, en trekt zijn conclusies uit de data. De opbouw van zo'n algoritme doet denken aan die van de neuronen in onze hersenen. Met genoeg gegevens kan zo’n algoritme vaardigheden leren zoals autorijden, Go spelen of kwaadaardige software opsporen.

Zeldzame dingen

Het probleem is dat de input voor de algoritmes vaak geen randgevallen bevat. De data komen immers uit de echte wereld (denk aan opnamen van een rijdende auto) en daar gebeuren zeldzame dingen nu eenmaal niet zo vaak.

De onderzoekers van de twee Amerikaanse universiteiten demonstreren met hun testprogramma hoe kwalijk dat is. Een bocht naar links wordt normaal prima genomen, maar verlaag de lichtintensiteit van het beeld een klein beetje en de auto kiest ervoor om zichzelf in de vangrail te boren.

Drie procent veiliger

Gelukkig bieden de onderzoekers ook meteen een oplossing. De randgevallen die ze testen, worden ook meteen als lesmateriaal aan het algoritme gevoerd, zodat het voortaan wel weet om te gaan met iets minder of iets meer licht. De nauwkeurigheid neemt daardoor volgens de onderzoekers toe met 3 procent. Dat lijkt weinig, maar het kan net het verschil zijn tussen een juiste beslissing of een fatale.

Het onderzoek laat tegelijkertijd zien dat er haken en ogen zitten aan deep learning. Als iemand ‘met de hand’ een algoritme programmeert, bouwt hij of zij doorgaans ook regels in voor uitzonderlijke scenario’s. Een deep-learning-algoritme doet dat van nature niet. Het is dus zaak dat softwarebouwers hun zelflerende algoritme aan strenge tests onderwerpen, inclusief de meest buitenissige randgevallen. Anders kan het dus behoorlijk mis gaan.

Beeld: de zelfrijdende auto van Google. Credit: Marc van der Chijs

Meer artikelen

Een AI-fabriek in Groningen

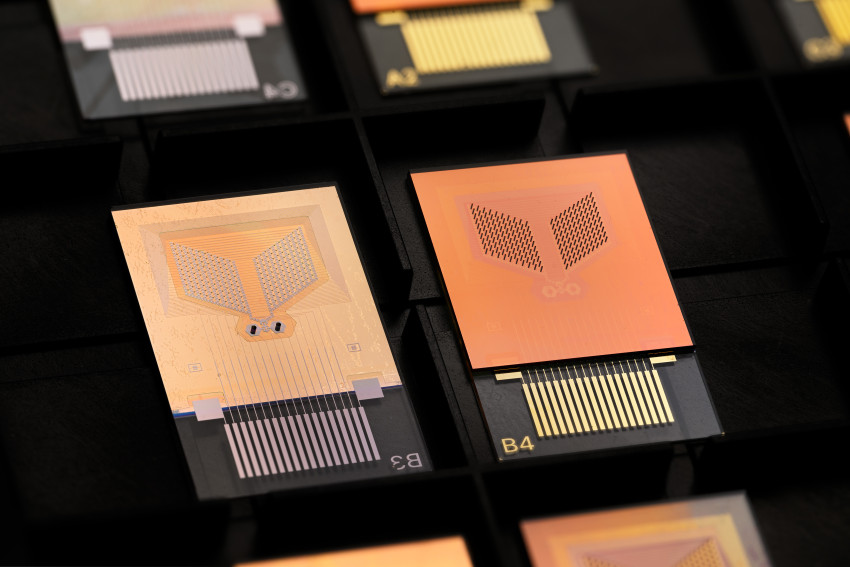

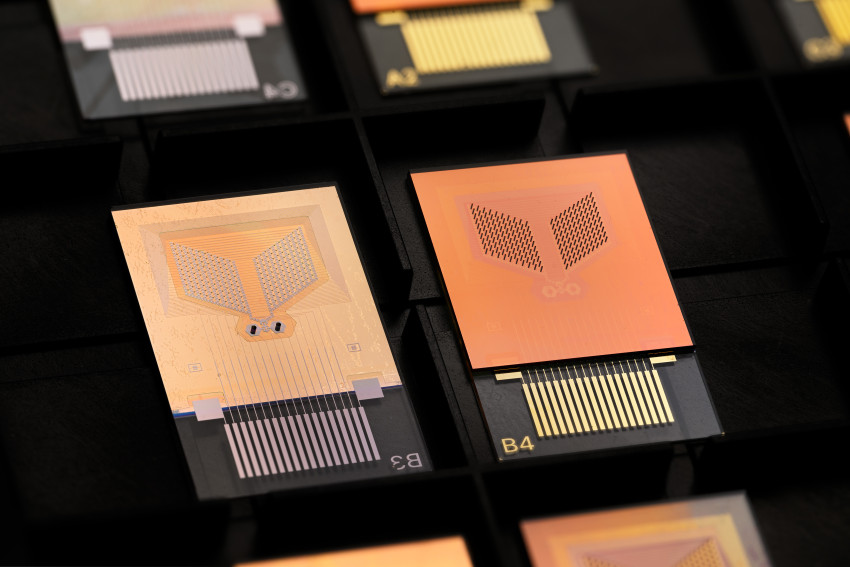

Gezondheid meten via zweetdruppels

Nieuwste artikelen

Een AI-fabriek in Groningen