Levensecht gezicht voor robot

Het is erg lastig om aan robots die op mensen moeten lijken een gezicht te geven dat emoties kan nabootsen. Amerikaanse onderzoekers presenteren een betaalbaar systeem gebaseerd op een half doorzichtig masker waarop een kleine beamer vanaf de achterkant een gezicht projecteert. De eerste tests zijn positief: het robotgezicht brengt emoties beter over dan een computerscherm.

Soms is het gewenst dat robots een gezicht krijgen dat menselijke emoties kan weergeven. Denk aan de zorg of het onderwijs van de toekomst, maar ook aan entertainment en helpdesks die draaien op basis van databases en kunstmatige intelligentie.

Fijnzinnige emoties

Hoewel we al snel menselijke eigenschappen toekennen aan apparaten (YouTube), blijkt het moeilijk robotgezichten te maken die onze fijnzinnig verschillende emoties weergeven. Soms valt de keuze op een puur mechanische oplossing, maar daarvoor zijn veel actuatoren nodig, wat het robotgezicht direct prijzig maakt. Duur in onderhoud en het is nagenoeg ondoenlijk om kleine aanpassingen door te voeren.

Daarom ontwikkelde een onderzoeksteam onder leiding van Ali Mollahosseini van de University of Denver in de VS een heel ander robotgezicht, ExpressionBot genaamd, gebaseerd op het projecteren van een pratend gezicht.

Masker naar vrouwengezicht

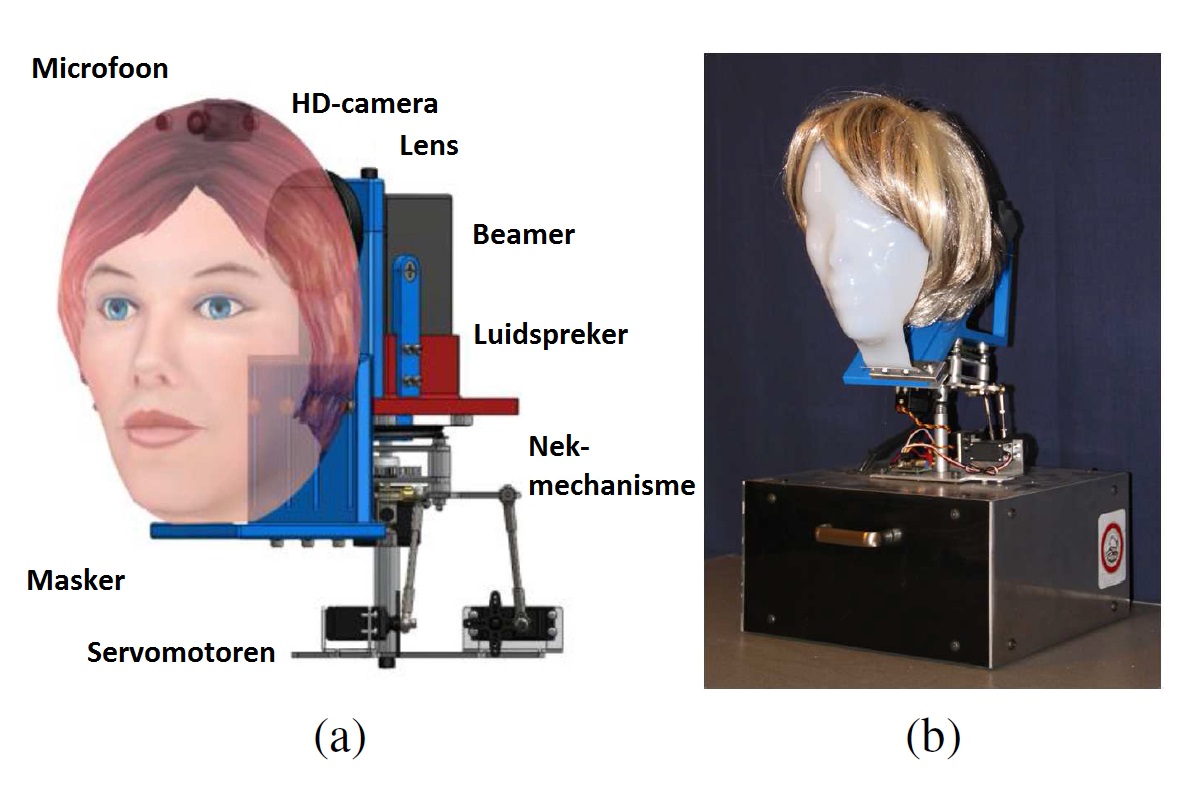

Zij goten uit wit lichtdoorlatend acrylaat een masker gevormd naar een vrouwengezicht. Achter het masker bevindt zich een kleine kleurenbeamer, gecombineerd met een fisheye-lens om het geheel van dichtbij scherp op de binnenkant van het masker af te beelden. Dit geheel staat op een systeem van servomotoren, dat de bewegingen van een menselijk hoofd en nek nabootst. Het bouwwerk wordt afgemaakt met een pruik die enerzijds het robotgezicht menselijk moet maken, maar tegelijk ook dient om strooilicht van de beamer tegen te houden. Aan de achterkant bevindt zich een luidspreker waaruit de uitgesproken klanken van ExpressionBot komen.

Tekening en foto van ExpressionBot. Bron: Ali Mollahosseini et al.

Vervolgens testten de onderzoekers het robotgezicht op een kleine groep proefpersonen. Daarbij werd dit steeds vergeleken met een tweedimensionale projectie van hetzelfde gezicht op een computerscherm.

Walging en boosheid

Uit de eerste test bleek dat de proefpersonen bijna alle belangrijke emoties goed van het robotgezicht konden halen. Behalve walging, die werd nogal eens verward met boosheid en verder leek de uitdrukking van angst bij de robot op droefheid.

In het tweede experiment sprak het robothoofd een stuk tekst uit, achtereenvolgens afkomstig van Margaret Thatcher en van een computerstem. Hier bleek dat de spraak van het robotgezicht als meer natuurlijk werd ervaren dan van een pratend gezicht op een computerscherm.

Mona Lisa-effect

Ten slotte deden de makers onderzoek naar het zogeheten Mona Lisa-effect, waarbij de blik van een persoon in een tweedimensionaal vlak altijd op de toeschouwer gericht lijkt te zijn, ongeacht waar die staat. Bij dit experiment zaten vijf proefpersonen gezamenlijk om het robotgezicht heen – in een wat surrealistische setting – onder een kijkhoek van respectievelijk 0, 25 en 45°. Het gezicht bewoog nu langs de kring mensen, terwijl de ogen steeds in een verschillende richting keken. Hieruit bleek dat de proefpersonen de kijkrichting van de robot beter konden inschatten dan van een gezicht op een scherm.

Het onderzoeksteam demonstreert met dit project dat robots op eenvoudige wijze – en betaalbaar, zij waren 1500 dollar aan materiaal kwijt – een gezicht kunnen krijgen met redelijk herkenbare menselijke emoties.

Illustratie opening: Pixar

Meer artikelen

Een AI-fabriek in Groningen

Gezondheid meten via zweetdruppels

Nieuwste artikelen

Een AI-fabriek in Groningen